Добрый день стереовчане.

Давненько исследую вопрос качества видеотракта и от чего он зависит и как его лучше потреблять. И пришел к выводу, скорее всего для многих он не откровение, что в нынешнее время в 50-70 % случаев стандарт Full HD будет предпочтительнее Ultra HD.

Понятное дело что стандарты, это не просто количество пикселей на экране, но и многие другие вещи. А рассудить я хочу сейчас о цветовой субдискретизации. Более подробно, можно узнать тут https://projectorworld.ru/blog/957.html.

Есть у нас FullHD, смотрим мы его в 8 бит и цветности RGB. HDMI 1.4 — вполне переварит через себя такие данные. Все хорошо, получаем по цветам максимум информации, если не брать глубину в 8 бит.

А есть у нас UltraHD, 10 бит, но цветность уже передается иначе, не в RGВ, а в яркости этих цветов Y'C'bC'r для каждого пикселя. Разделяется она на три основных профиля:

4:4:4 — тот же RGB, вы ничего не теряете в цветах и все хорошо, по факту если вы смотрите контент в 4K, без HDR в 8 Bit - ваш цветовой профиль должен быть 4:4:4

4:2:2 — тут чуть сложнее, выкидывается часть яростного канала по цветам, что дает экономию пропускной способности, грубого говоря — это Lossless профиль, ваш глаз вряд ли заметит разницу.

4:2:0 — это MP3, теряем 50-70 % цветовой информации, что весьма плохо.

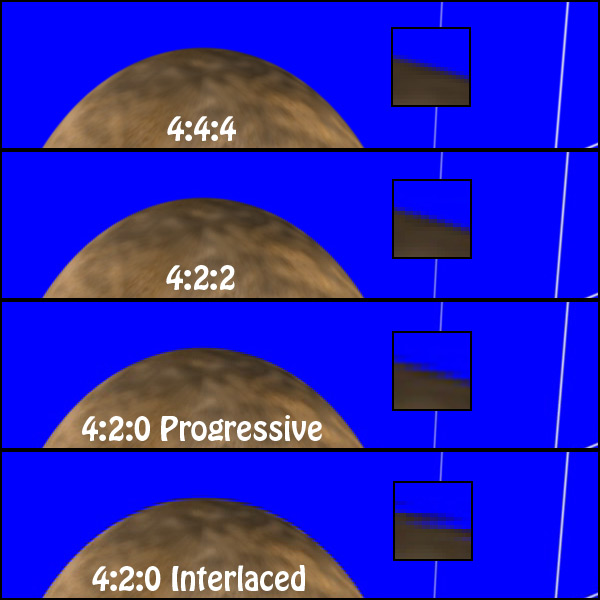

Выглядит это примерно так

Очень большие потери идут на гранях объектов или текста, вы теряете четкость цвета. По факту разрешение цвета.

В итоге у нас есть высокие требования по общей яркости и яркости цветов.

Но, такой массивный объем данных требует очень много пропускной способности. В итоге даже не каждый HDMI 2.0 переварит через себя это, надежда только на HDMI 2.1 или оптику HDMI 2.1 до 24 Гбит в сек. Медные HDMI 2.0 до 5 метров, еще смогут переживать сигнал 4K/10 бит/ 4.2.2 в 24 Гц, но 4.4.4 в 24 Гц уже не факт, все зависит от производителя, а о 50-60 ГЦ, что требуется в новых консолях этого точно не будет.

Выходит, что если у вас идет сигнал, например, через медный HDMI 2.0 метров 10, то вы получаете, не полноценный формат UltaHD, а скорее всего 4K 10 бит 4:2:0.

Часть контента мастерится именно в 4:2:0, но очень большая часть идет именно в 4:2:2, у меня 90 % это 4:2:2 — если мы говорим о кино. Лично для себя вижу разницу, в глубине сцены и ее насыщенности между 1080p RGB и контентом 8 бит 4K (4:2:0) и не в пользу последнего.

Такие небольшие мысли в слух, а может для кого-то повод обновить HDMI кабель на более приличный